1 安装 Ollama

访问 ollama 官网点击下载 Windows 版本安装包。

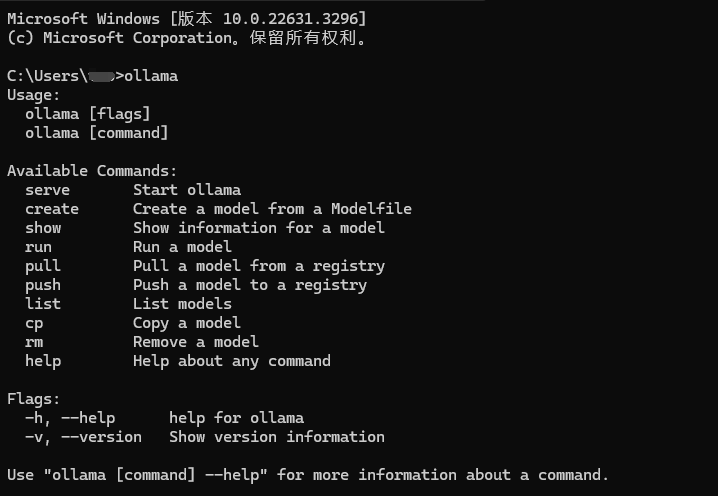

安装成功后,打开 cmd 终端输入 ollama ,安装成功则会出现以下信息。

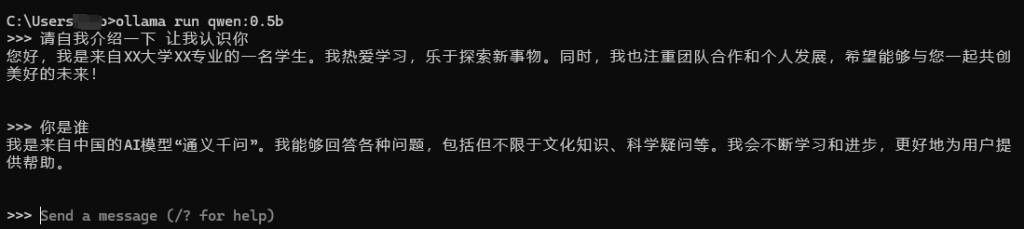

2 运行本地模型

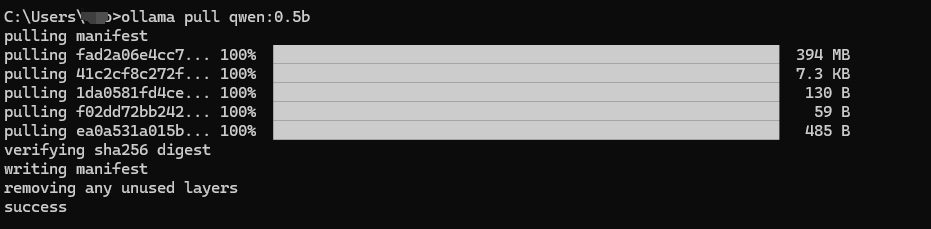

拉取模型

ollama pull qwen:0.5b

运行模型

ollama run qwen:0.5b

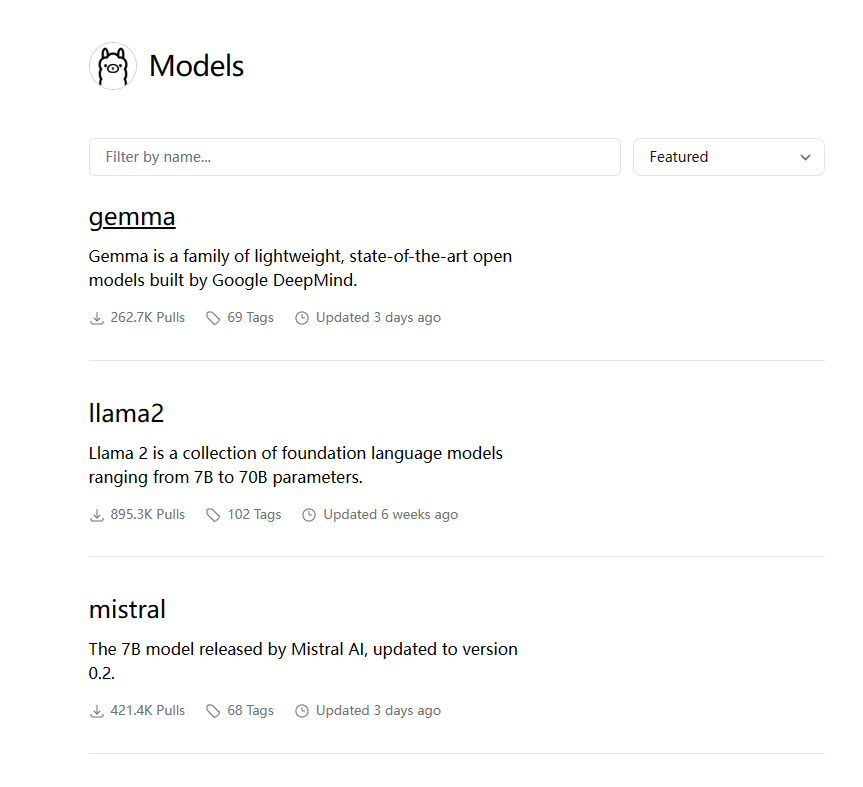

3 下载运行其他模型

访问 ollama 模型下载页面,查看可用的模型,如下图所示:

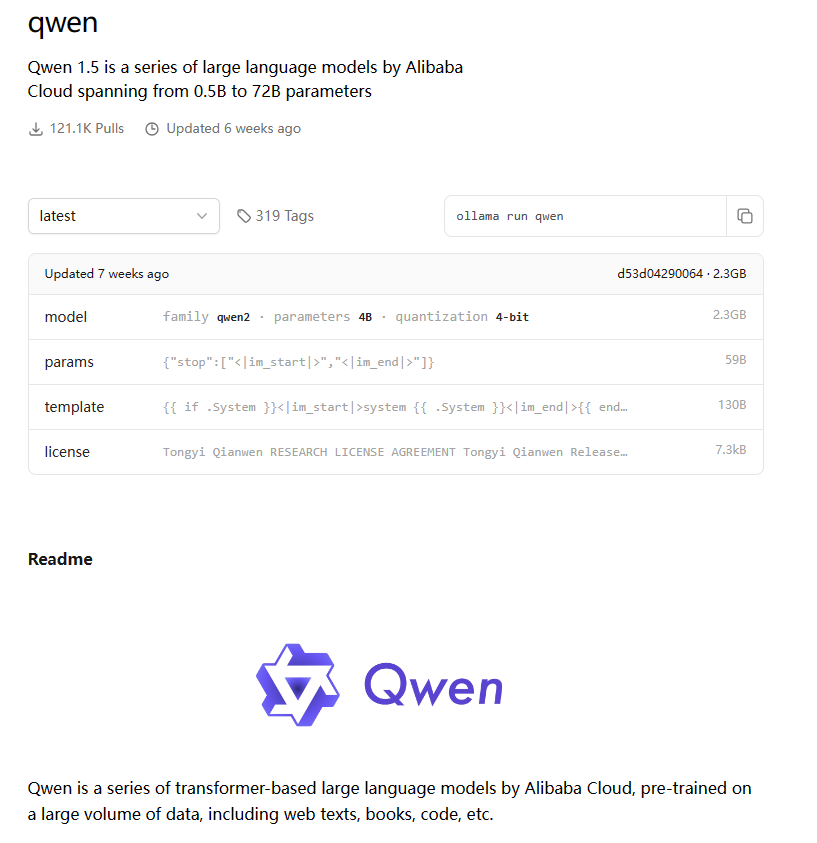

点击某一个模型查看其模型详情,详情中Readme 中有模型的介绍信息,如下图所示:

如 qwen 一共有 6 种模型,分别是 0.5B,1.8B,4B,14B,72B, 如执行 ollama run qwen:0.5b 会直接启动其语言模型,如语言模型不存在则会自动下载。

6 model sizes, including 0.5B, 1.8B, 4B (default), 7B, 14B, and 72B

ollama run qwen:0.5b

ollama run qwen:1.8b

ollama run qwen:4b

ollama run qwen:7b

ollama run qwen:14b

ollama run qwen:72b4 开启 ollama Api服务

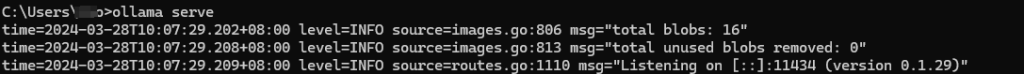

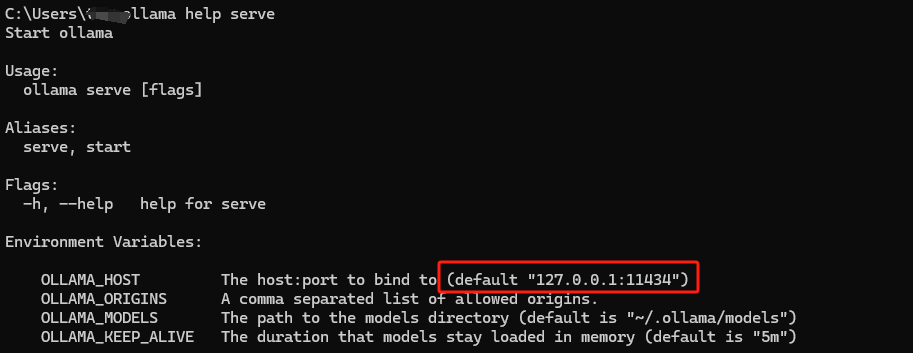

4.1 ollama 开启本地服务

执行 ollama serve 即可开启 ollama 的服务,外部应用通过服务即可调用 ollama 的 Api 。Ollama 服务默认是地址是 127.0.0.1:11434

4.2 ollama 开启对外服务

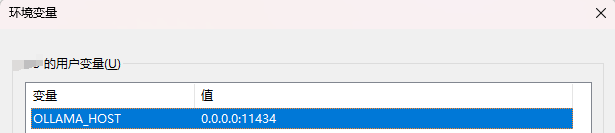

在Windows 系统中需要在环境变量中添加 OLLAMA_HOST,具体值如下图所示:

环境变量配置成功后,执行 ollama serve 即可对外开放 Api 服务。